情绪检测(TensorFlow)

该数据集包含35,685个48x48像素灰度图像的示例,分为训练数据集和测试数据集。根据面部表情中显示的情绪对图像进行分类(快乐、中性、悲伤、愤怒、惊讶、厌恶、恐惧)。

Mask R-CNN(PyTorch)

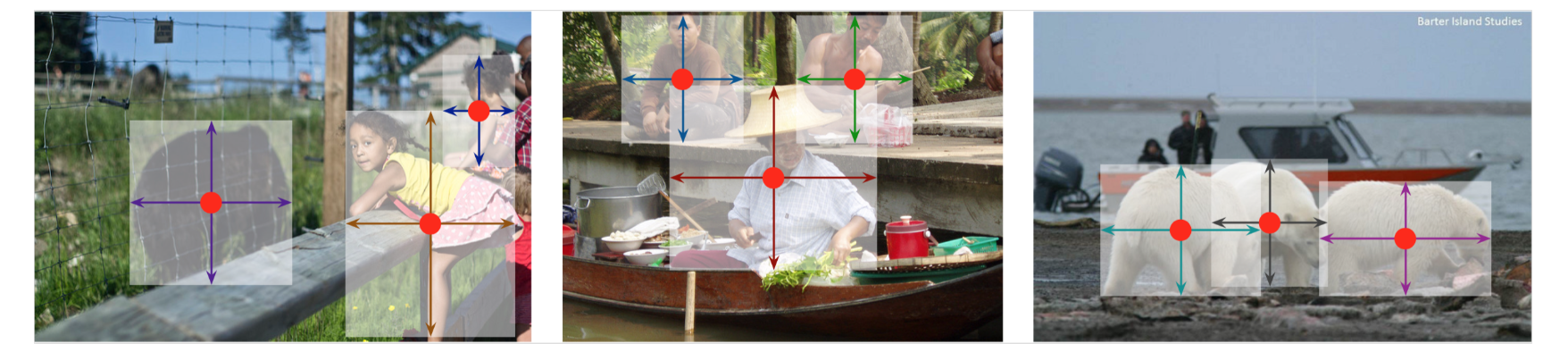

Mask R-CNN方法可以有效地检测图片中的物体,同时为每个实例生成高质量的分割掩模。通过添加一个用于与现有的边界框识别分支并行预测对象掩模的分支来扩展Faster R-CNN。Mask R-CNN训练起来很简单,只给Faster R-CNN增加了很小的开销,运行速度为5fps。此外Mask R-CNN很容易推广到其他任务。下面有一个实例:”检测显微镜图像中的单个神经元细胞“。

利用Transformer(DETR)进行端到端的物体监测

DETR (Detection Transformer)

物体检测是一个不仅复杂而且计算成本较高的问题。《Attention is all you need》,是Transformers的论文,推动了了NLP的发展,并且达到了很高的高度。虽然主要是为NLP开发的,但围绕它的最新研究重点是如何在深度学习的不同垂直领域利用它。Transformer架构非常非常强大,这就是我有动力探索使用Transformer的原因。Detection Transformer利用Transformer网络(编码器和解码器)来检测图片中的物体。Facebook的研究人员认为,对于物体检测,图片的一部分应该与图片的另一部分接触以获得更好的结果,特别是对于被遮挡的物体和部分可见的物体,这比使用Transformer更好。DETR背后的主要动机是有效地消除对许多手工设计组件的需求,例如非极大值抑制过程或锚点生成,这些组件显式编码有关任务的先验知识,并使过程变得复杂且计算成本高昂。新框架的主要组成名为DEtection TRansformer或DETR,是基于集合的全局损失,通过二分匹配强制进行的预测,以及Transformer编码器-解码器架构。

机器学习模型 — 介绍

AI Agent — 思考

AI的发展方向我们认为主要有两个:一个是有趣、亲和、更像人的AI;另一个是有用、严谨、更像工具的AI。AI更像工具还是更像人呢?其实有很多争议。就技术的发展阶段来说:目前很长一段时间应该是”更像工具的AI“,未来的某个时间节点会朝着”更像人的AI“方向发展。

多级分类-图片分类(CNN & 迁移学习)

NLP(Preprocessing when using embeddings)

我想说明在构建深度学习NLP模型时如何进行有意义的预处理。

- 当有预先训练的嵌入时,不要使用标准预处理步骤,例如词干提取或停用词删除。

- 让你的词汇尽可能接近嵌入。

NLP(GloVe & BERT & TF-IDF & LSTM)

自然语言处理(NLP)是人工智能的一个分支,它负责连接机器以自然语言理解人类。自然语言可以是文本或声音的形式。NLP可以用人类的方式与机器进行交流。文本分类是情感分析中涉及的内容。它是将人类的意见或表达分类为不同的情绪。情绪包括正面、中立和负面、评论评级以及快乐、悲伤。 情绪分析可以针对不同的以消费者为中心的行业进行,分析人们对特定产品或主题的看法。自然语言处理起源于20世纪50年代。早在1950年,艾伦·图灵就发表了一篇题为《计算机器与智能》的文章,提出了图灵测试作为智能的标准,这项任务涉及自然语言的自动解释和生成,但当时尚未明确阐述。在此内核中,我们将重点关注文本分类和情感分析部分。