机器学习(ML)(二十二) — 强化学习探析

RLHF

人类反馈的强化学习(RLHF)是一种结合了人类反馈与强化学习技术的机器学习方法,旨在提高人工智能模型的表现,尤其是在生成式人工智能(如LLM)中的应用。人类反馈的强化学习(RLHF)的核心思想是利用人类提供的反馈来优化机器学习模型,使其能够更好地满足用户需求和期望。传统的强化学习依赖于预定义的奖励函数来指导学习,而RLHF则将人类的主观反馈纳入其中,以便更灵活地捕捉复杂任务中的细微差别和主观性。

RLHF通常包括以下几个步骤:

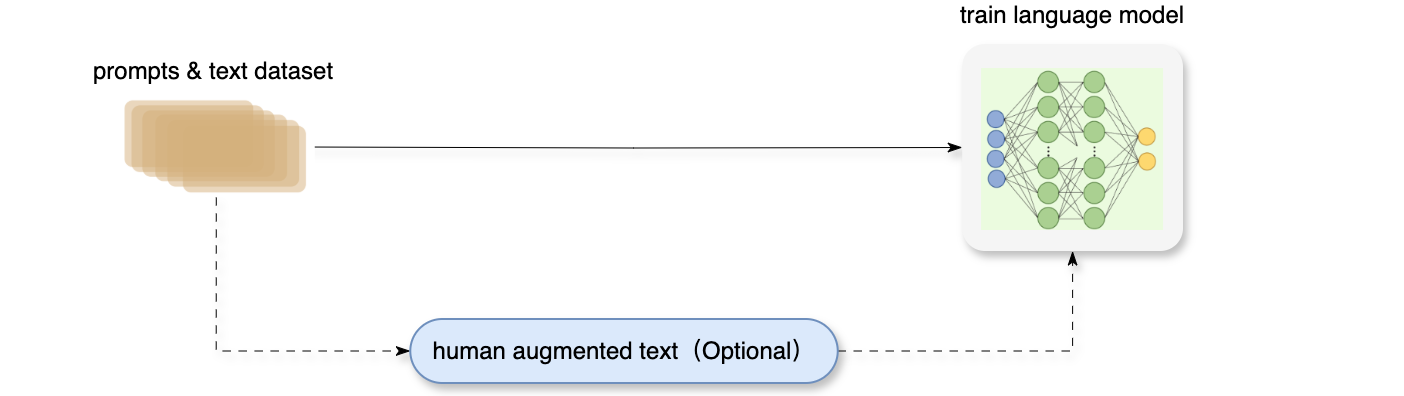

- 预训练语言模型:首先,使用大量标注数据对语言模型进行预训练。这一步骤通常通过监督学习完成,以确保模型能够生成合理的初步输出。

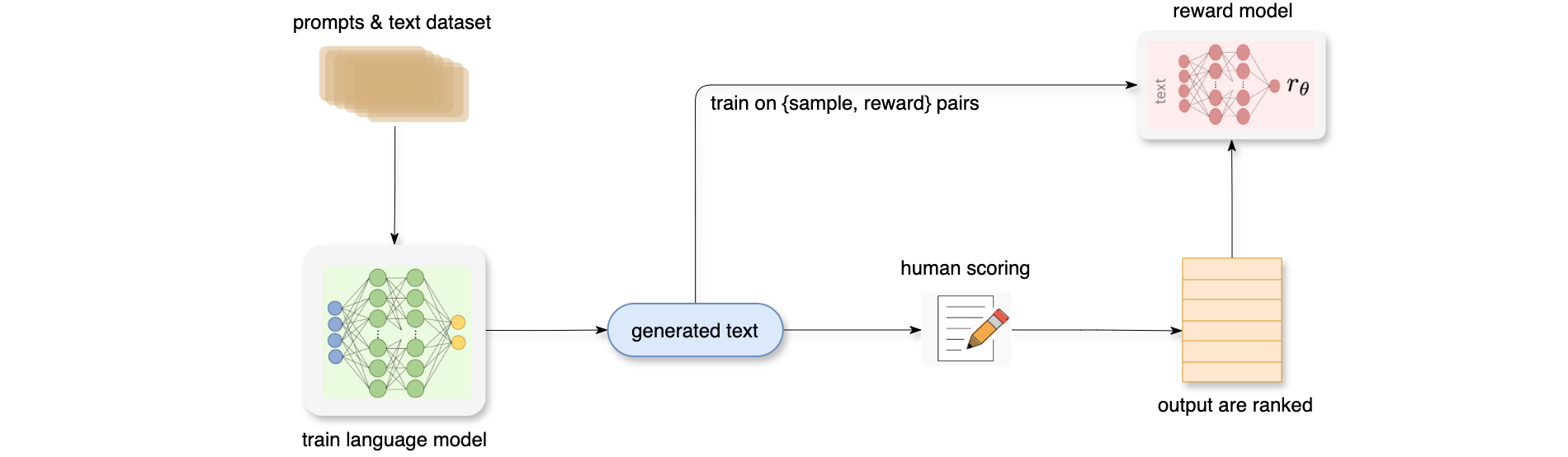

- 训练奖励模型:在此阶段,生成多个可能的问答,并由人类评估这些问答的质量。人类反馈被用于训练一个奖励模型,该模型能够评估生成内容的好坏。

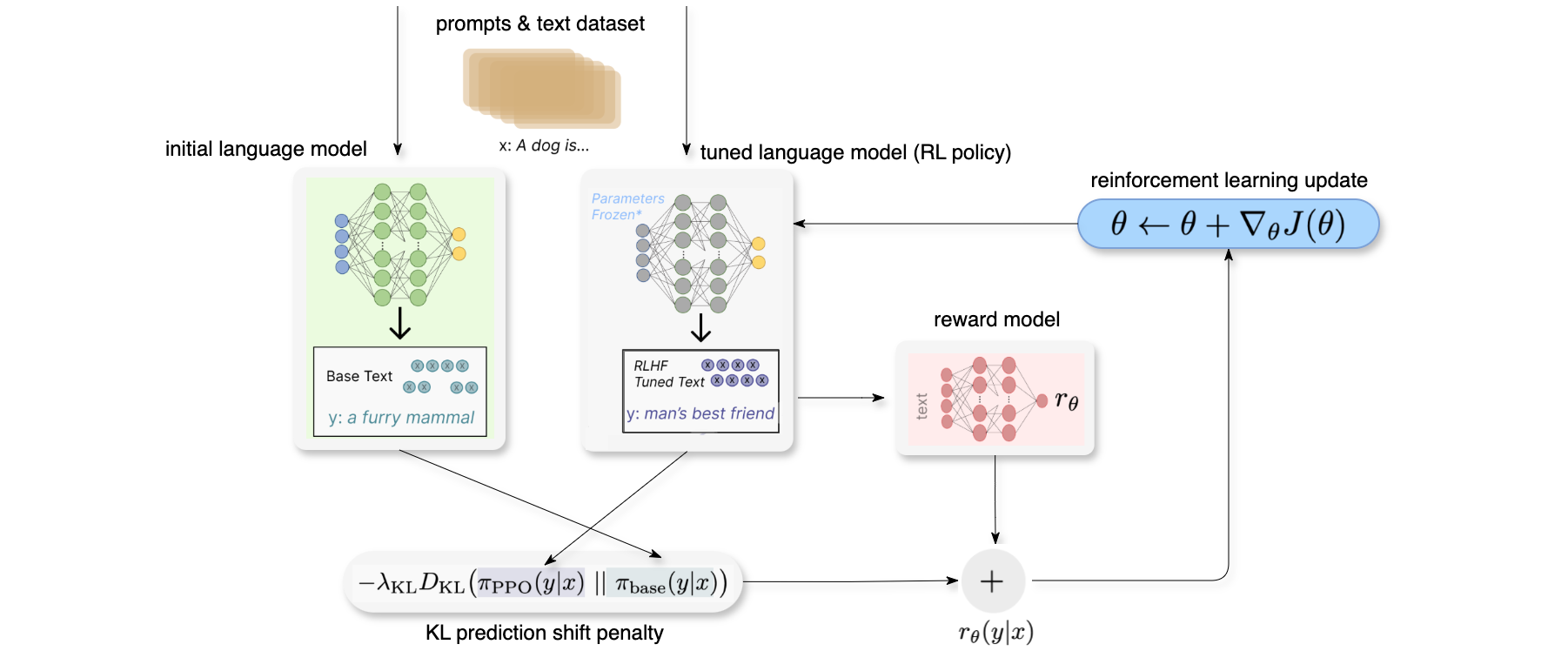

- 强化学习微调:最后,使用训练好的奖励模型对语言模型进行微调,通过强化学习算法(如近端策略优化:

PPO)进一步优化其表现,以便更好地符合人类反馈和偏好。

人类反馈的强化学习(RLHF)在多个领域展现了其重要性,尤其是在自然语言处理(NLP)和生成式AI中。通过引入人类反馈,RLHF能够:提高生成内容的人性化程度,使得AI生成的文本更符合人类的沟通习惯和情感表达;增强适应性,AI系统能够根据实时反馈调整其行为,解决复杂任务,在一些难以明确量化成功标准的任务中,RLHF提供了一种有效的方法来利用人类直观判断作为反馈。适应不断变化的用户需求和偏好。人类反馈的强化学习(RLHF)是一种前沿技术,通过将人类直观反馈与强化学习结合起来,为生成式AI的发展提供了新的方向。它不仅提高了AI系统与用户之间的互动质量,也为复杂任务提供了新的解决方案。

预训练语言模型

首先,使用经典的预训练目标训练一个语言模型,对这一步模型,OpenAI在其第一个RLHF模型的InstructGPT中使用了较小版本的GPT-3;Anthropic使用了1000万 ~ 520亿参数的Transformer模型进行训练;DeepMind使用了自家的2800亿参数模型Gopher。这里可以用额外的文本或者条件对这个LM进行微调,例如OpenAI采用 “更可取”(preferable)的人工生成文本进行了微调;而Anthropic采用了“有用、诚实和无害” 的标准在上下文线索上蒸馏了原始的LM。这里或许使用了昂贵的增强数据,但并不是RLHF必要的一步。由于RLHF还是一个尚待探索的领域,对于” 哪种模型” 适合作为RLHF的起点并没有明确的答案。

训练奖励模型

奖励模型 (RM,也叫偏好模型)的训练是RLHF区别于旧范式的开端。这一模型接收一系列文本并返回一个标量奖励,数值上对应人的偏好。我们可以用端到端的方式用LM建模,或者用模块化的系统建模 (比如对输出进行排名,再将排名转换为奖励) 。这一奖励数值将对后续无缝接入现有的RL算法至关重要。关于模型选择方面,奖励模型可以是另一个经过微调的LM,也可以根据偏好数据从头开始训练的LM。例如Anthropic提出了一种特殊的预训练方式,即用偏好模型预训练(Preference Model Pretraining,PMP)来替换一般预训练后的微调过程。因为前者被认为对样本数据的利用率更高。但对于哪种奖励模型更好尚无定论。

关于训练文本方面,奖励模型 的提示-生成对文本是从预定义数据集中采样生成的,并用初始的LM给这些提示生成文本。Anthropic的数据主要是通过Amazon Mechanical Turk上的聊天工具生成的,并在Hub上可用,而 OpenAI使用了用户提交给GPT API的prompt。

关于训练奖励数值方面,这里需要人工对LM生成的回答进行排名,起初可能会认为应该直接对文本标注分数来训练奖励模型,但是由于标注者的价值观不同导致这些分数未经过校准并且充满噪声。通过排名可以比较多个模型的输出并构建更好的规范数据集。对具体的排名方式,是对不同的LM在相同提示下的输出进行比较,然后使用Elo(评分系统,是一种用于计算棋手和其他竞技游戏玩家相对技能水平的方法)系统建立一个完整的排名。这些不同的排名结果将被归一化为用于训练的标量奖励值。

强化学习微调

长期以来出于工程和算法原因,人们认为用强化学习训练LM是不可能的。而目前多个组织找到的可行方案是使用策略梯度强化学习(Policy Gradient RL)算法、近端策略优化(Proximal Policy Optimization,PPO)微调初始LM的部分或全部参数。因为微调整个10B~100B+参数的成本过高。首先将微调任务表述为强化学习问题。该策略是一个接受提示并返回一系列文本(或文本的概率分布)的LM。这个策略的动作空间(action space)是LM的词表对应的所有词元 (一般在50k数量级),观察空间(observation space)是输入词元序列,也比较大(词汇量 x 输入标记的数量)。奖励函数是奖励模型和策略转变约束(Policy shift constraint)的结合。PPO算法的奖励函数计算如下:将提示(prompt)OpenAI、Anthropic和DeepMind的多篇论文中设计为输出词分布序列之间的Kullback–Leibler (KL) divergence散度的缩放,即OpenAI在InstructGPT上实验了在PPO添加新的预训练梯度,可以预见到奖励函数的公式会随着RLHF研究的进展而继续进化。最后根据PPO算法,按当前批次数据的奖励指标进行优化(来自PPO算法on-policy的特性)。PPO算法是一种信赖域优化(Trust Region Optimization,TRO)算法,它使用梯度约束确保更新步骤不会破坏学习过程的稳定性。DeepMind对Gopher使用了类似的奖励设置,但是使用A2C(synchronous advantage actor-critic)算法来优化梯度。

作为一个可选项,RLHF可以通过迭代奖励模型和策略共同优化。随着策略模型更新,用户可以继续将输出和早期的输出进行合并排名。Anthropic在他们的论文中讨论了迭代在线RLHF,其中策略的迭代包含在跨模型的Elo排名系统中。这样引入策略和奖励模型演变的复杂动态,代表了一个复杂和开放的研究问题。收集人类偏好数据的质量和数量决定了RLHF系统性能的上限。RLHF系统需要两种人类偏好数据:人工生成的文本和对模型输出的偏好标签。除开数据方面的限制,一些有待开发的设计选项可以让RLHF取得长足进步。例如对RL优化器的改进方面,PPO是一种较旧的算法,但目前没有什么结构性原因让其他算法可以在现有RLHF工作中更具有优势。另外,微调LM策略的成本是策略生成的文本都需要在RM上进行评估,通过离线RL优化策略可以节约这些大模型RM的预测成本。最近,出现了新的RL算法如隐式语言Q-Learning(Implicit Language Q-Learning,ILQL) 也适用于当前RL的优化。在RL训练过程的其他核心权衡,例如探索和开发(exploration-exploitation) 的平衡也有待尝试和记录。

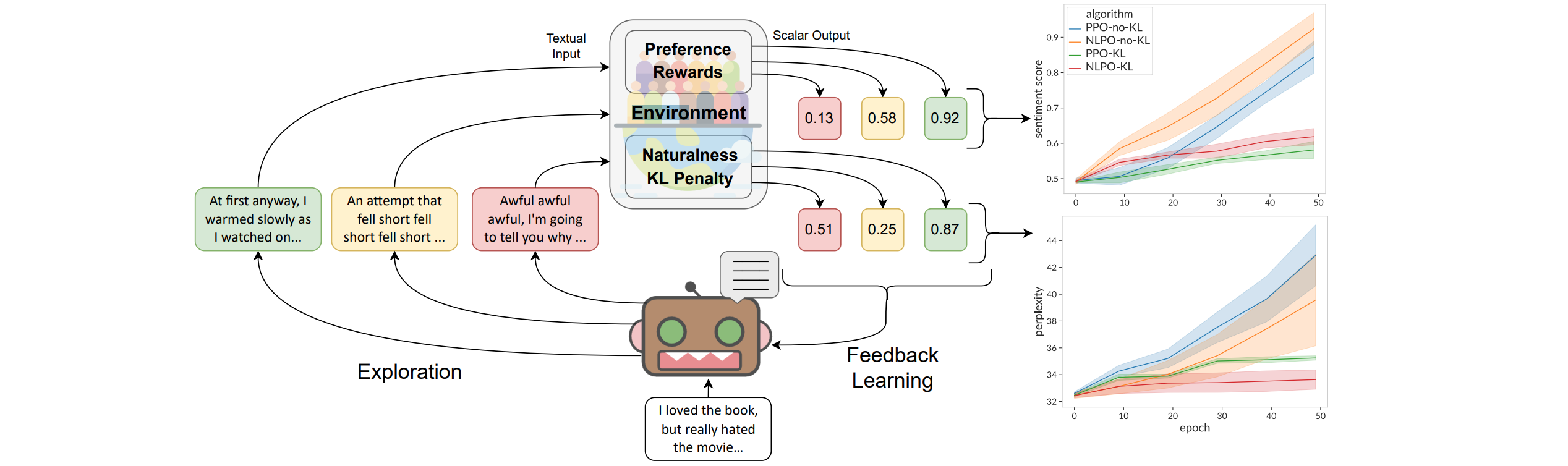

NLPO

大多数语言模型在训练时并没有直接的人类偏好信号,监督目标字符串仅作为代理。一个整合用户反馈的选项是采用人机协作,即用户在模型训练过程中需要为每个样本提供反馈,但这种密集监督的程度往往是不可行且低效的。自动化指标提供了一个有前景的折衷方案:如成对学习偏好模型、BERTScore、BLEURT等人类偏好的模型,与早期指标(如BLEU、METEOR等)相比,显著提高了与人类判断的相关性,并且评估成本较低。然而,这些函数通常不是逐词可微分的:与人类一样,这些指标只能对完整生成结果提供质量估计。强化学习(RL)为优化不可微分的标量目标提供了一条自然路径。最近的研究表明,通过约束基于偏好的奖励来结合流畅性概念,强化学习(RL)在将LM与人类偏好对齐方面取得了很好的结果,但这一研究方向的进展受到缺乏开源基准和算法实现的严重阻碍——导致人们认为强化学习(RL)是NLP的一个具有挑战性的范式。为了促进构建强化学习(RL)算法以更好地对齐语言模型(LM)。首先,发布了RL4LMs库,使得生成HuggingFace模型(如GPT-2或T5)能够使用多种现有的强化学习(RL)方法进行训练,例如PPO、A2C等。接下来,使用RL4LMs训练的模型应用于新的GRUE(通用强化语言理解评估)基准:GRUE是一个包含7个NLP任务的集合;与其他基准不同的是,每个任务配对奖励函数,而不是进行监督训练。GRUE保证模型在保持流畅的语言生成能力的同时,优化这些奖励函数。通过强化学习(RL)训练语言模型——无论是否进行任务监督预训练——以优化奖励。最后,除了现有的强化学习(RL)方法,还引入了一种新颖的在线强化学习(RL)算法——自然语言策略优化(NLPO),该算法能够在逐词级别动态学习任务特定的约束。实验结果和人类评估表明,与其他方法相比,自然语言策略优化(NLPO)在学习偏好奖励的同时,更好地保持了语言流畅性,包含了PPO的能力。在使用标量奖励反馈进行学习时,发现强化学习(RL)可以更具:数据效率,优于通过监督学习使用额外专家示范(尽管两者结合是最佳选择)——当作为自然语言策略优化(NLPO)方法的信号时,学习到的奖励函数在性能上优于使用5倍数据训练的监督方法;参数效率——使得一个结合监督和自然语言策略优化(NLPO)训练的2.2亿参数模型超越一个30亿参数的监督模型。

在情感引导的续写任务中,自然语言策略优化(NLPO)旨在使语言模型(即策略)根据评论提示生成积极的情感续写。这里需要平衡两个目标:1、作为奖励的自动化人类偏好智能体(此处为情感分类器);2、通过与未经过显式人类反馈训练的语言模型之间的KL散度来衡量“自然性”。如下图所示,自然语言策略优化(NLPO)与流行的策略梯度(PPO)的验证学习曲线比较。如果去掉自然KL惩罚(naturall KL penalty),强化学习(RL)方法可以轻松获得高奖励,但代价是更高的困惑度。建议方法:NLPO + KL成功地在奖励和自然性之间取得了比以往研究更有效的平衡。

模仿学习(Imitation Learning, IL)是一种强化学习范式,旨在通过从专家示范中进行监督学习来执行任务。许多与自然语言处理(NLP)相关的算法,如调度采样(Schedule Sampling, SS)、并行调度采样(Parallel SS)、Transformer调度采样、差分调度采样(Differential SS)、LOL(Learning to Optimize Language Sequences)、TextGAIL和SEARNN,都受到DAGGER和SEARN的启发。然而,这些算法在生成过程中普遍存在偏差和马尔可夫决策过程(MDP)问题。在大动作空间强化学习中,MIXER结合了调度采样和REINFORCE的思想。actor-critic算法解决了REINFORCE进行语言生成时的方差和大动作空间问题;KG-A2C、TrufLL、AE-DQN和GALAD通过消除和减少探索过程中的动作空间来解决类似问题。

RL4LMs是一个开源库,提供了用于微调和评估基于语言模型(LM)的强化学习(RL)算法的构建模块。该库是基于HuggingFace和stable-baselines-3构建。RL4LMs可以用于训练HuggingFace中的任何解码器或编码器-解码器Transformer模型,并支持来自stable-baselines-3的任何在线强化学习算法。此外,还提供了针对LM微调的在线强化学习算法的实现,例如PPO、TRPO、A2C和NLPO。该库是模块化的,用户可以插入自定义环境、奖励函数、指标和算法。在初始版本中,支持6种不同的NLP任务、16种评估指标和奖励,以及4种强化学习算法。

每个环境都是一个自然语言处理(NLP)任务:我们有一个监督数据集MDP)MDP中的每个回合从数据集中抽取一个数据点EOS)标记时结束。输入PARENT这样的自动化指标。RL4LMs提供了一个类似OpenAI Gym的API,用于模拟这种基于LM的MDP公式。这种抽象允许快速添加新任务,并与所有已实现的算法兼容。

由于RL4LMs提供了一个通用接口,用于每个标记或每个序列生成奖励,因此可以快速将各种强化学习算法应用于多样化的文本指标作为奖励。提供了以下接口:

n-gram重叠指标,如ROUGE、BLEU、SacreBLEU、METEOR。- 基于模型的语义指标,如

BertScore和BLEURT,这些指标通常与人类判断具有更高的相关性。 - 特定任务指标,如

CIDER、SPICE(用于图像描述/常识生成)、PARENT(用于数据到文本生成)和SummaCZS(用于摘要的真实性)。 - 多样性/流畅性/自然性指标,如困惑度、平均分段类型标记比率(

MSSTR)、单词和双词的香农熵、不同n-gram的比例(Distinct-1、Distinct-2),以及在整个生成文本中仅出现一次的n-gram数量。 - 基于模型的人类偏好的特定任务指标,在

Ouyang等人的方法中收集的人类偏好数据上训练的分类器。

RL4LMs支持通过在线actor-critic算法对语言模型进行微调和从头训练。这类算法允许训练一个参数化的控制策略,定义为actor-critic算法一样,价值函数和Q值函数为:

优势函数的定义为:

为了提高训练的稳定性,优势使用广义优势估计(Generalized Advantage Estimation)进行近似。给定输入输出对Wu的方法,使用逐标记的KL惩罚来正则化奖励函数,以防止模型过度偏离初始化的语言模型

其中KL奖励,KL系数

语言生成的动作空间比大多数离散动作空间的强化学习(RL)算法设计的要大几个数量级,例如,GPT-2和GPT-3的词汇大小分别为50K和32K。动作空间的大小是使用现有强化学习方法训练语言模型时不稳定的核心原因。为了解决这个问题,需要引入了NLPO(自然语言策略优化),该方法受到动作消除/无效动作掩蔽工作的启发。NLPO是PPO的一个参数化掩蔽扩展,学习在训练过程掩蔽上下文中不太相关的token。NLPO通过top-p采样实现这一点,该方法将token限制在其累积概率大于概率参数

具体而言,NLPO维护一个掩蔽策略top-p标记来创建一个参数化的无效掩蔽,然后对剩余标记应用无效掩蔽——即在训练期间从0;这种周期性更新的策略Q-Learning算法的启发,为策略KL惩罚之间的关系,以及奖励操纵的风险。NLPO算法的伪代码实现如下:

PSRL

在强化学习(RL)中,智能体面临与未知环境互动的任务,同时试图最大化随时间累积的总奖励。强化学习(RL)中的一个核心挑战是如何平衡:当采取探索性动作时,智能体会获得更多未知环境的知识,利用获得的知识可能会产生更高的即时回报。基于汤普森采样(Thompson sampling)开发随机化探索方法。虽然这些方法已被证明有效,但它们在很大程度上局限于情节环境。具体而言,其操作模式是在每个情节开始之前随机采样一个新策略,该策略旨在最大化在统计上合理的环境模型中的期望回报,并在整个情节中遵循该策略。例如,bootstrapped DQN维护一个近似最优动作值函数PSRL)的后验采样版本,该版本易于扩展以适应复杂环境中的函数逼近。称为持续PSRL,在每个时间点以概率bootstrapped DQN,以应对持续环境。与bootstrapped DQN的原始版本一样,每次执行的动作都是相对于最近采样的动作值函数贪婪选择的。

许多理论研究将折扣因子PSRL版本,通过直接在无折扣遗憾下进行规划。Ouyang等人提出的算法在每次满足以下两个条件之一时,从环境后验中重新采样环境:1、自上次重采样以来经过的时间超过两次最近重采样之间的间隔;2、自上次重采样以来,任何状态-动作对的访问次数翻倍。后者条件发挥着重要作用,但在复杂环境中操作时不可行,例如,处理不可计算的大状态空间并使用神经网络近似动作值函数的分布。特别是,如何有效跟踪访问计数并不明确,即使能做到这一点,这些计数也可能无关紧要,因为访问任何单个状态超过一次甚至可能很少。为了解决大状态空间问题,Theocharous等人考虑简单地将每对连续重采样之间的时间延长一倍。尽管生成的算法避免了维护访问计数,但他们的分析严重依赖技术假设,否则遗憾界限将随着时间线性增长。随机探索的重采样方法——包括固定和递减重置概率,并进行了严格分析,该分析建立了类似于Ouyang等人的遗憾界限,但其重采样标准比该文中提出的方法更简单、更可扩展。

通过与未知环境MDP)。在这里,[0,1]内。为了简化,假设奖励函数Lu等人(2021)提出的算法状态概念

其中期望的下标表示奖励序列是通过遵循策略

弱通信MDP:如果存在一组状态,其中该组中的每个状态都可以通过某种确定性静态策略从该组中的每个其他状态访问,同时可能存在一个在每种策略下都是瞬态的空状态集,则该MDP被称为弱通信。在弱通信MDP下,最优平均奖励

遗憾本身是一个随机变量,依赖于随机环境

Continuing PSRL是一种针对持续强化学习环境的后验采样算法,旨在解决在无限时间范围内的平均奖励问题。它是对传统后验采样强化学习(PSRL)算法的扩展,特别适用于复杂的高维状态空间,避免了维护状态-动作访问计数的需求。主要特征包括:

- 随机重采样机制:在每个时间步,

Continuing PSRL以一定概率 - 无折扣奖励规划:该算法通过简单的随机化方案决定何时重采样新模型,并且在重采样时使用的是无折扣奖励,以便更好地适应持续学习的场景。

- 性能保证:

Continuing PSRL在表格设置下建立了

在有限时间的马尔可夫决策过程中,规划的时间范围是固定且已知的。规划目标通常是每个回合结束前有限时间步内的累积奖励。当时间范围为无限时,智能体的前瞻性规划变得具有挑战性。解决这一挑战的一种方法是通过维持折扣因子

折扣值:在每个时间步,智能体优化一个带有上述折扣因子discounted折扣值函数

在马尔可夫决策过程(MDP),对于所有状态0,因此其长度Bellman Equation),该方程描述了状态价值与即时奖励和后续状态价值之间的关系。贝尔曼方程表示为:

奖励平均时间:策略

对于所有Bartlett和Tewari(2009)中的跨度(span)概念。定义MDPMDP。此定义强调了在评估策略性能时,奖励平均时间的关键作用。奖励平均时间反映了在给定环境和策略下,智能体需要多长时间才能稳定地估计其长期平均奖励,从而影响其学习和决策过程。通过引入这一概念,我够更好地理解和分析在不同环境下智能体的表现及其遗憾界限。存在

对于所有

我们再次注意到,对于弱通信的环境

对所有状态

折扣遗憾:为了分析算法在

定义伪回合

经验估计:定义算法使用的经验转移概率。令

对于所有

持续后验采样强化学习(Continuing Posterior Sampling for Reinforcement Learning, CPSRL)算法,该算法将后验采样强化学习(PSRL)扩展到具有CPSRL)从基于当时可用历史

与传统的PSRL相比,持续后验采样强化学习(CPSRL)仅增加了一个独立的伯努利随机数生成器来决定何时重新采样。尽管持续后验采样强化学习(CPSRL)并不是专门设计用于实际应用,但这种重新采样机制带来了可扩展性和通用性。例如,当环境具有极大的状态或动作空间时,例如Atari游戏(Mnih et al., 2015),依赖于状态-动作访问统计的先前重新采样方法需要一个庞大的查找表,而持续后验采样强化学习(CPSRL)中的重新采样方法仍然可以应用,并且计算开销很小。将后验采样强化学习(PSRL)扩展到环境没有重置计划的情境下,智能体必须在无限时间范围内进行规划。理论上证明了持续后验采样(CPSRL)具有接近理论最优性的遗憾上界。值得注意,持续后验采样强化学习(CPSRL)仅依赖于一个伯努利随机数生成器来重新采样环境,而不是以往工作中复杂的回合停止方案。这种设计原则可以很容易地应用于具有大状态空间的一般环境。在表格和连续的RiverSwim环境中的模拟展示了该方法的有效性。此外,持续后验采样强化学习(CPSRL)还突出了折扣因子在智能体设计中的作用,因为折扣因子不再被视为学习目标的一部分,而主要作为智能体动态调整其规划时间范围的工具。因此,这项工作可能为理解折扣因子提供了重要的一步,而折扣因子在强化学习应用中已经广泛流行。

总结

强化学习受到了至少3种教条的影响。第一种是环境聚光灯,这指的是倾向于关注建模环境而非智能体。第二种是将学习视为找到任务解决方案,而不是适应的过程。第三种是奖励假设,认为所有目标和目的都可以被视为最大化奖励信号。这三种教条塑造了我们对强化学习的理解。

在《科学革命的结构》中,托马斯·库恩区分了科学活动的两个阶段:第一个阶段被称为“常规科学”,库恩将其比作解谜;第二个阶段被称为“革命”阶段,涉及对科学基本价值、方法和承诺的重新构想,库恩统称为“范式”。人工智能(AI)的历史可以说经历了这两个阶段之间的多次波动,以及多个范式的更替。第一个阶段始于1956年的达特茅斯研讨会(McCarthy et al., 2006),并且可以说一直持续到1973年Lighthill等人发布的报告,这一报告被认为对第一次AI寒冬的到来产生了重大影响(Haenlein & Kaplan, 2019)。在此后的几十年中,我们见证了多种方法和研究框架的兴起,如符号AI(Newell & Simon, 1961;2007)、基于知识的系统(Buchanan et al., 1969)和统计学习理论(Vapnik & Chervonenkis, 1971;Valiant, 1984;Cortes & Vapnik, 1995),知道近年来,深度学习(Krizhevsky et al., 2012;LeCun et al., 2015;Vaswani et al., 2017)和大语言模型(Brown et al., 2020;Bommasani et al., 2021;Achiam et al., 2023)的出现标志着人工智能领域的重要发展。当放宽这些教条时,会得到一种将强化学习视为智能体科学研究的观点,这一愿景与强化学习和人工智能的经典教材(Sutton & Barto, 2018;Russell & Norvig, 1995)以及控制论(Wiener, 2019)的既定目标密切相关。作为重要的特殊情况,这些智能体可能与马尔可夫决策过程(MDP;Bellman, 1957;Puterman, 2014)进行了互动,寻求特定问题的解决方案,或在存在奖励信号的情况下进行学习,以最大化该信号,但这些并不是唯一感兴趣的情况。

教条一:环境聚光灯

第一个教条为环境聚光灯,它指的是集体关注于建模环境和以环境为中心的概念,而非智能体。例如,智能体本质上是解决马尔可夫决策过程(MDP)的工具,而不是一个独立的、具体的模型。人工智能科学的本质最终是关于智能体的,然而,我们的思维方式,以及数学模型、分析和核心结果往往围绕解决特定问题展开,而不是围绕智能体本身。换句话说,我们缺乏一个规范的智能体正式模型。这就是第一个教条的本质。专注于环境的意思是需要搞清楚以下2个问题:1、在强化学习中,至少有一个规范的环境数学模型是什么?2、在强化学习中,至少有一个规范的智能体数学模型是什么?这些问题的重点在于,尽管我们在强化学习中对环境的建模有明确的框架和理论基础,但对于智能体本身的建模却缺乏相应的规范模型。这种不平衡反映了我们在研究中对环境的过度关注。

第一个问题(什么是规范的环境模型?)有一个直接的答案:马尔可夫决策过程(MDP),或其附近的变体,如k-臂老虎机、上下文老虎机或部分可观察马尔可夫决策过程(POMDP)。每个模型都编码了不同版本的决策问题,受不同结构假设的影响——以马尔可夫决策过程(MDP)为例,通过假设存在一个可维护的信息集合(称之为状态),该状态是下一个奖励和同一信息集合的下一个分布的充分统计量,从而做出了马尔可夫假设。假设这些状态由环境定义,并且在每个时间步都可以被智能体直接观察,以用于学习和决策。部分可观察马尔可夫决策过程(POMDP)放宽了这一假设,而是仅向智能体揭示观察结果,而不是状态。通过接受MDP,能够引入多种算法。例如,知道每个MDP至少有一个确定性的、最优的、静态的策略,并且动态规划可以用来识别该策略(Bellman, 1957;Blackwell, 1962;Puterman, 2014)。此外,还探索了马尔可夫决策过程(MDP)的变体,例如块状MDP(Du et al., 2019)、丰富观察MDP(Azizzadenesheli et al., 2016)、面向对象的MDP(Diuk et al., 2008)、Dec-POMDP(Oliehoek et al., 2016)、线性MDP(Todorov, 2006)和分解MDP(Guestrin et al., 2003)等。这些模型各自突出了不同类型的问题或结构假设,并激发了大量启发性的研究。

第二个问题(什么是规范的智能体模型?)没有明确的答案。可能会倾向于用一种特定的流行学习算法(指在机器学习和强化学习领域中广泛应用的一类算法),例如Q-Learning,但这是错误的。Q-Learning只是可以支持智能体的逻辑的一种实例,但它并不是对智能体是什么的通用抽象,无法与MDP作为广泛序列决策问题模型的地位相提并论。我们缺少一个规范的智能体模型,甚至缺乏一个基本的概念框架。在当前阶段,这已成为一个限制,部分原因在于对环境的关注。实际上,专注于以环境为中心的概念(例如动态模型、环境状态、最优策略等)往往会掩盖智能体自身的重要角色。因此,在探索直接涉及智能体的问题时能力不足。但在这里,希望审视以智能体为中心的范式的兴趣,这样可以提供探索智能体原则所需的概念清晰性。如果没有这样的基础,难以准确定义和区分关键的智能体家族,如“有模型”和“无模型”智能体,或研究有关智能体与环境边界(Jiang, 2019;Harutyunyan, 2020)、扩展心智(Clark & Chalmers, 1998)、嵌入式代理(Orseau & Ring, 2012)、具身性影响(Ziemke, 2013;Martin, 2022)或资源约束影响(Simon, 1955;Ortega et al., 2015;Griffiths et al., 2015;Kumar et al., 2023;Aronowitz, 2023)等更复杂的问题。大多数以智能体为中心的概念通常超出了基本数学语言的范围。替代方案:关注智能体,除了问题和环境外,定义、建模和分析智能体也很重要。应该朝着一个规范的智能体数学模型迈进,我们应该进行基础工作,以建立表征重要智能体属性和家族的公理。借鉴心理学、认知科学、哲学、生物学、人工智能和博弈论等多个研究智能体的学科。这样做可以扩大科学研究的视野,以理解和设计智能体。

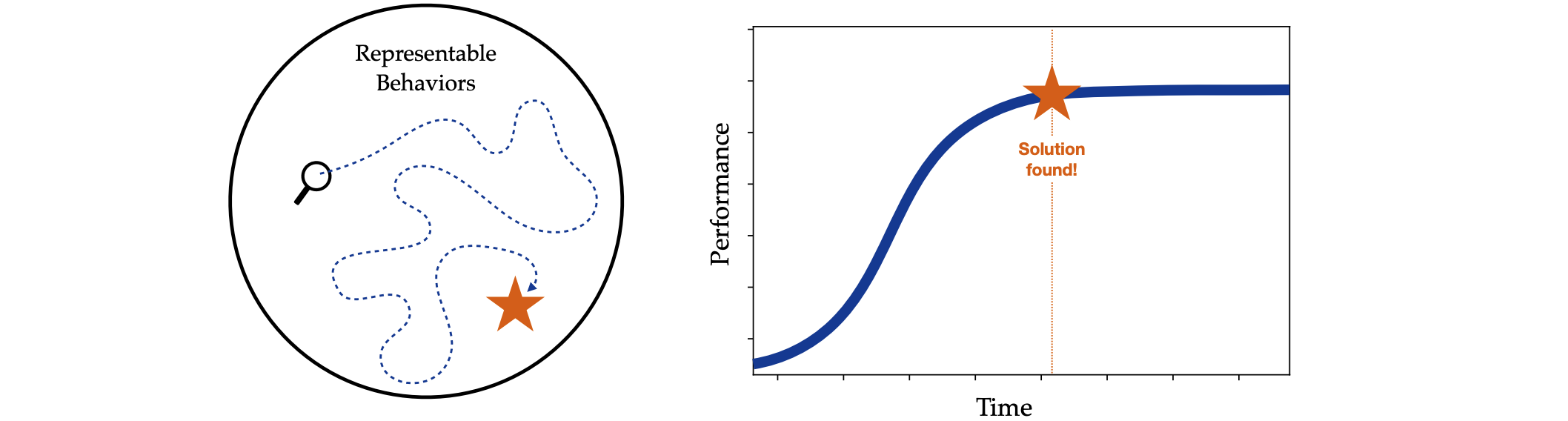

教条二:学习作为寻找解决方案

第二个教条嵌入在对学习概念的处理方式中。倾向于将学习视为一个有限的过程,涉及对给定任务的解决方案的搜索和最终发现。例如,考虑一个强化学习智能体学习玩棋盘游戏的经典问题,如双陆棋或围棋。在这些情况下,通常假设一个好的智能体会进行大量游戏,以学习如何有效地玩游戏。最终在足够多的游戏之后,智能体将达到最佳玩法,并可以停止学习,因为所需的知识已经获得。换句话说,我们往往隐含地假设设计的学习智能体最终会找到当前任务的解决方案,此时学习可以停止。也同样出现在许多经典基准测试中,在这些测试中,智能体会学习直到达到目标。从某种角度看,这些智能体可以被理解为在可表示函数的空间中搜索,这些函数捕捉了智能体可用的动作选择策略,类似于问题空间假设(Newell, 1994)。关键是,这个空间至少包含一个函数——例如MDP的最优策略——其质量足以认为任务已解决。通常,希望设计能够保证收敛到终点的学习智能体,此时智能体可以停止其搜索(停止学习)。这种观点嵌入到许多目标中,并且很自然地将马尔可夫决策过程(MDP)作为决策问题模型来使用。众所周知,每个MDP至少有一个最优的确定性策略,并且可以通过动态规划或其近似方法进行学习或计算。替代方案:学习作为适应。接受学习也可以被视为适应的观点。因此,我们的关注将从最优性转向一种强化学习问题的版本,其中智能体不断改进,而不是专注于试图解决特定问题的智能体。当然,这种问题的版本已经通过终身学习(Brunskill & Li, 2014;Schaul et al., 2018)、多任务学习(Brunskill & Li, 2013)和持续强化学习(Ring, 1994;1997;2005;Khetarpal et al., 2022;Anand & Precup, 2023;Abel et al., 2023b;Kumar et al., 2023)的视角进行了探索。当我们从最优性转向适应性时,如何看待评估?如何准确地定义这种学习形式,并将其与其他形式区分开来?执行这种学习形式的基本算法构建块是什么?它们与今天使用的算法有何不同?标准分析工具,如遗憾和样本复杂度,仍然适用吗?这些问题都很重要。

教条三:奖励假设

第三个教条是奖励假设,其表述为:“我们所理解的所有目标和目的都可以被视为最大化所接收标量信号(奖励)累积和的期望值”。首先,是要承认,这一假设并不值得被称为“教条”。最初提出时,奖励假设旨在对目标和目的的思考,类似于之前的期望效用假设。而且,奖励假设为强化学习的研究奠定了基础,促成了许多应用和算法的发展。然而,在继续追求智能体设计的过程中,认识到这一假设的细微差别。特别是,Bowling等人(2023)的最新分析,全面阐明了奖励假设成立所需的隐含条件。这些条件有两种形式。首先,Bowling等人提供了一对解释性假设,澄清了奖励假设为真或为假的含义——大致上,这可以归结为两点。第一,“目标和目的”可以通过对结果的偏好关系来理解。第二,如果由价值函数引导的智能体排序与由智能体结果上的偏好引导的排序相匹配,则奖励函数捕捉到这些偏好。在这种解释下,只有当偏好关系满足4个冯·诺依曼-摩根斯坦公理以及Bowling等人称之为-Temporal无差异的第5个公理时,马尔可夫奖励函数才存在以捕捉偏好关系。这一点非常重要,因为它表明,当写下一个马尔可夫奖励函数以捕捉期望的目标或目的时,我们实际上是在强迫目标或目的遵循这5个公理。也就是说,某些抽象美德,如幸福和正义,可能被认为是不可比较的。或者,同样,两种具体经历可能是不可测量的,例如在海滩散步和吃早餐——我们如何能用相同的标准来衡量这些经历呢?Chang指出,两项事物可能在没有进一步参考特定用途或上下文的情况下不可比较:“一根棍子不能比一颗台球更大……它必须在某方面更大,例如质量或长度。”然而,第一个公理,即完备性,严格要求隐含的偏好关系在所有经验对之间分配真实偏好。因此,如果认为奖励假设为真,只能在拒绝不可比较性和不可测量性的情况下,将目标或目的编码到奖励函数中。值得注意的是,完备性特别受到Aumann的批评,因为它对持有偏好关系的个体提出了要求。最后,完备性公理并不是唯一限制可行目标和目的空间的公理;第三公理,无关选择的独立性,由于阿莱悖论拒绝了风险敏感目标。实际上,Skalse和Abate(2023)证明马尔可夫奖励无法捕捉风险敏感或多标准目标,而Miura(2022)同样证明多维马尔可夫奖励在表达能力上严格优于标量。替代方案:认识并接受细微差别。意识到标量奖励的局限性,并对描述智能体目标的其他语言保持开放态度。当通过奖励信号来表示一个目标或目的时,重要的是要认识到对可行目标和目的所施加的隐含限制。值得强调的是,偏好本身只是表征目标的另一种语言——可能还有其他语言,因此在思考目标追求时,采取广泛的视角是很重要的。

强化学习(RL)的长期愿景是为智能体科学提供一个整体范式。为了实现这一愿景,是时候重新审视与塑造强化学习的3种隐含教条的关系。这3种教条过于强调环境、找解决方案,以及奖励作为描述目标的语言。此外,应该将智能体视为研究的中核心对象之一。其次,必须超越仅研究为特定任务寻找解决方案的智能体,转而研究那些能够从经验中不断改进的智能体。最后,应该认识到将奖励作为目标语言的局限性,并考虑其他替代方案。规范智能体模型是什么?如智能体与环境边界、具身性、资源约束和嵌入式代理。学习的目标是什么?当找不到最优解决方案时,如何看待学习?我们如何开始评估这样的智能体,并衡量它们的学习进展?